00后华裔小哥哈佛辍学组团挑战英伟达,史上最快AI芯片Sohu推理性能超H100二十倍!

以下文章来自新智元,作者:新智元

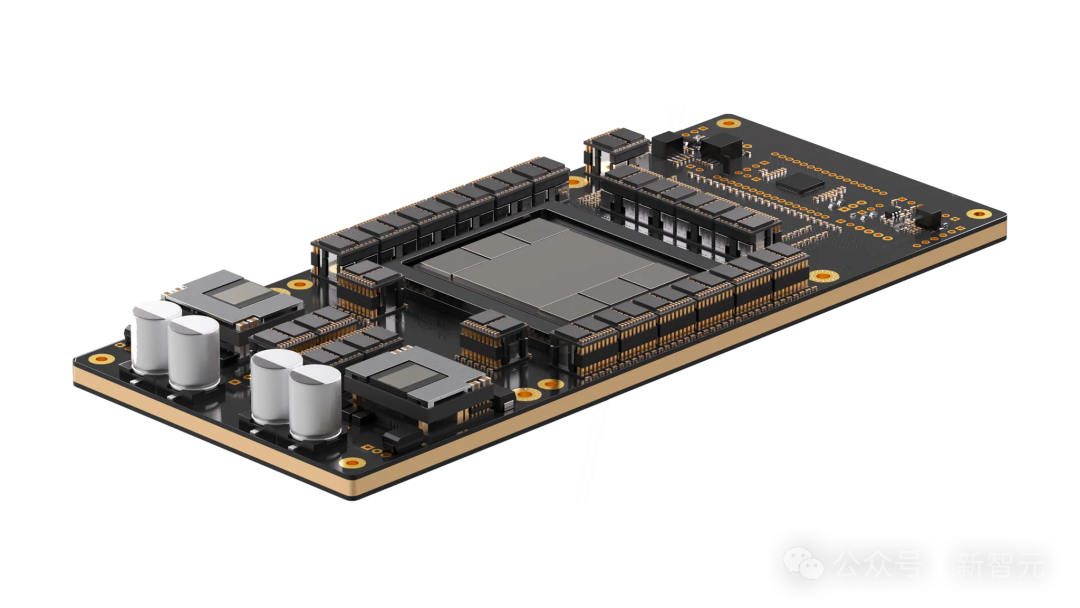

有史以来最快的 Transformer 芯片,刚刚诞生了?

去年 21 岁哈佛辍学华裔小哥的神级创业故事,进化到了新的阶段。

这一次,号称专为 LLM 推理加速打造的 Sohu 芯片,已经成超越 Groq,成为最强 AI 芯片。

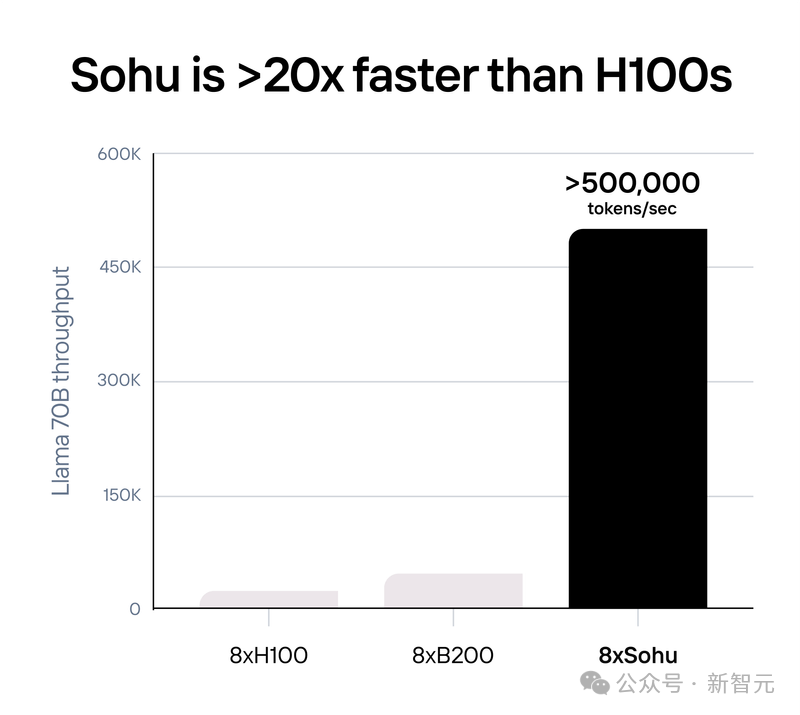

如今的 Sohu,在跑 Llama 70B 时每秒可生成高达 500000 个 token 的输出。

换句话说就是:1 张 Sohu≈20 张 H100≈10 张 B200。

在去年 12 月,Etced 就曾火过一阵,当时两位哈佛辍学小哥的 2 人公司,估值已经高达 3400 万刀。当时 Sohu 号称 LLM 推理性能达到 H100 的 10 倍,单价吞吐量更是高达 140 倍。

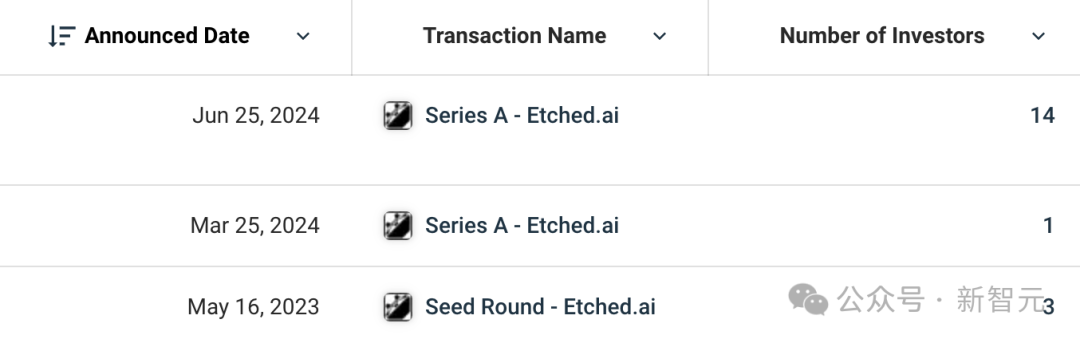

而就在刚刚,Etced 又宣布了炸裂的新消息:已筹到 1.2 亿美元。

就在上周,英伟达的市值达到 3.3 万亿美元,超过微软成为全球第一。而 Etched 相信,自己的 35 人团队能够击败英伟达。

他们的豪放预言,得到了硅谷真金白银的支持。投资名单中,是一众豪华的机构和硅谷大佬,包括 Peter Thiel。

Primary Venture Partners和Positive Sum Ventures领投了这轮融资,机构投资者包括 Hummingbird、Fundomo、Fontinalis、Lightscape、Earthshot、Two Sigma Ventures和 Skybox Data Centers。

天使投资者包括Peter Thiel、Stanley Druckenmiller、David Siegel、Balaji Srinivasan、Amjad Masad、Kyle Vogt、Kevin Hartz、Jason Warner、Thomas Dohmke、Bryan Johnson、Mike Novogratz、Immad Akhund、Jawed Karim和Charlie Cheeve。

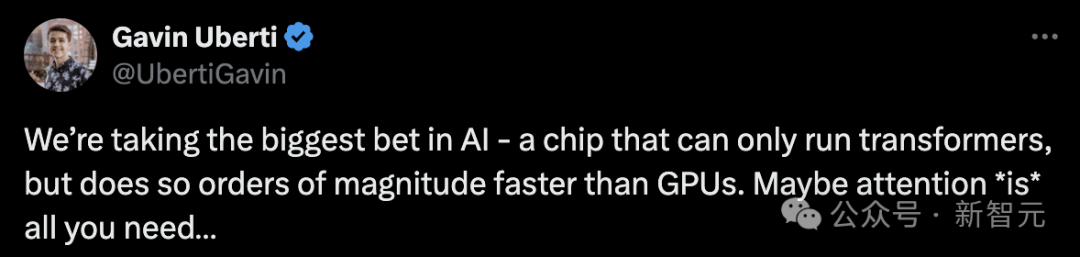

Etched 创始人之一 Gavin Uberti 表示,「我们正在押注人工智能领域最大的赌注——一种只能运行 Transformer 模型的芯片,但其运行速度比 GPU 快几个数量级。也许注意力确实是你所需要的全部...」

Pika研究人员表示,每秒 50 万 token 简直太疯狂了。你可以在 2 秒内写出「圣经」,或者一年内生成 15 万亿 token。

Sohu 大约每秒能输出 21 个人一天说的话,简直太不真实了。

Thiel Fellowship 的主任 Alex Handy,对几位年轻人表示了高度的赞许:「投资 Etched 是对 AI 价值的战略性押注。他们的芯片解决了竞争对手不敢面对的可扩展性问题,挑战了同行中普遍存在的停滞状态。」

在他看来,正是因为几位小哥做了底层的工作,硅谷的程序员们才能继续安心编程,不必担心正在开发技术的底层出问题。

两年前开始的豪赌

这个传奇的故事,始于两年前。

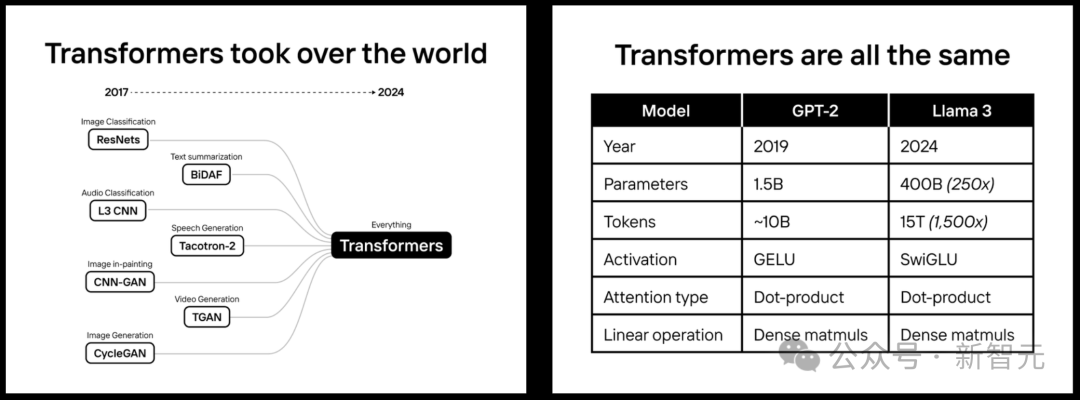

2022 年,几位创始人就打赌:Transformer 将占领世界。

为此,他们花了两年时间打造 Sohu,这是世界上第一个用于 Transformer 的专用芯片(ASIC)。

将 Transformer 架构烧录到 Sohu 芯片后,它无法运行大多数的传统 AI 模型:比如 DLRMs、AlphaFold 2,或 Stable Diffusion 2;也无法运行 CNNs、RNNs 或 LSTMs。

但对于 Transformer 来说,Sohu 确实是有史以来最快的芯片。但它还可以更快。

对于 Llama 70B,Sohu 的吞吐量每秒超过了 50 万个 token,因此它可以构建在 GPU 上根本不可能实现的产品。

而且,它甚至比英伟达的下一代 Blackwell(B200)更快、更便宜!

如今最先进的AI模型,无一不是基于 Transformer 的,比如 ChatGPT、Sora、Gmini、Stable Diffusion 3 等等。

如果 Transformer 被 SSM、RWKV 或任何新架构取代,那 Sohu 将毫无用处。

但是,创始人小哥表示,如果他们押对了,Sohu 将彻底改变世界!

这,就是一场豪赌。

Scale 是「超级智能」所需的全部?

五年内,AI 模型在大多数标准化测试中,超越了人类。

这是怎么做到的?

因为 Meta 用于训练 Llama 400B(2024 年 SOTA 模型)的计算量,比 OpenAI 训练 GPT-2(2019 年 SOTA 模型)多 5 万倍。

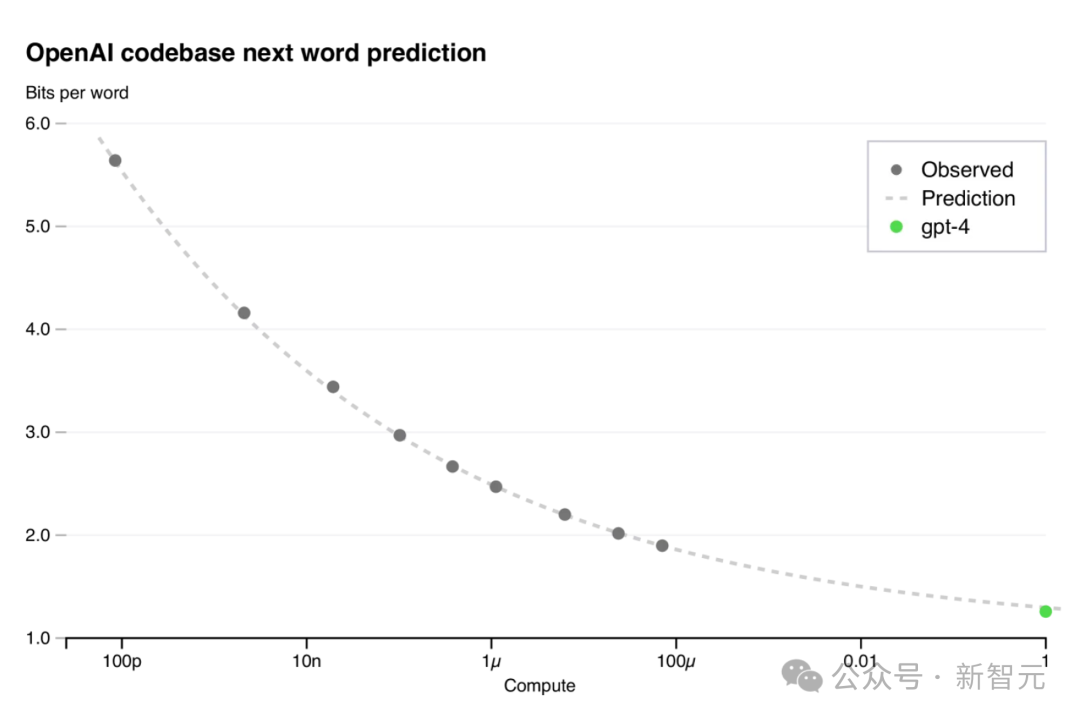

OpenAI 用 Scaling Law 预测了 GPT-4 性能,并预计 GPT-5+ 同样适用

奥特曼曾说过,「扩展参数规模确实非常重要。当我们在太阳周围建造了一个戴森球(Dyson Sphere)之后,我们才可以考虑讨论是否应该停止这么做,但在那之前不应该停下来」。

也就是说,通过向 LLM 提供更多的算力和更好的数据,才使得AI变得更加智能。

不得不承认,参数规模扩展(Scale)将会是几十年来唯一持续有效的方法。

每个大型 AI 公司(谷歌、OpenAI/微软、Anthropic/亚马逊等)都在未来几年投入超 1000 亿美元来继续扩大 LLM 规模。

然而,再扩展 1000 倍必定是昂贵的,形象地解释,下一代数据中心的成本将超过一个小国的 GDP。

按照目前的发展速度,我们的硬件、成本、财力根本无法跟得上。

GPU 撞墙了

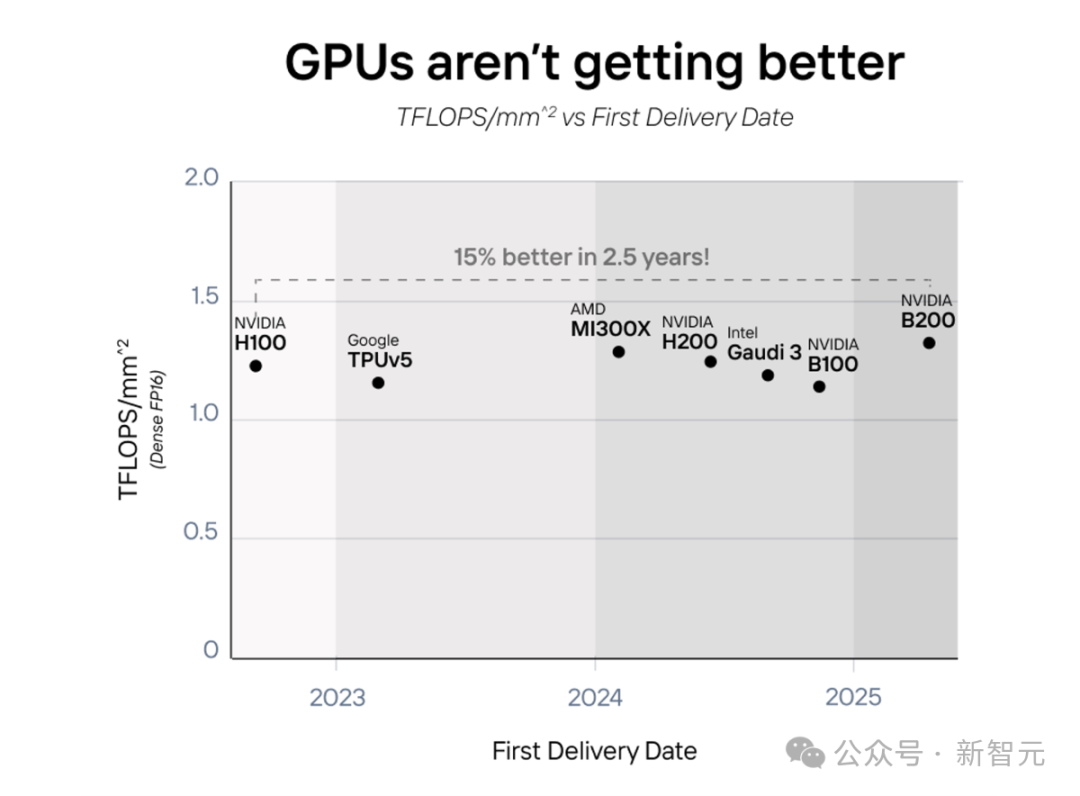

圣克拉拉,英伟达总部所在地,不愿意让人知道的小秘密是——GPU 性能其实没有变得更好,只是变得更大了。过去四年里,芯片单位面积的计算能力(每平方毫米的 TFLOPS)几乎没有提升。

就比如,英伟达的 B200、AMD 的 MI300、英特尔的 Gaudi 3,以及亚马逊的 Trainium2 都将 2 个芯片集成到一张卡上,以使其性能翻倍。

如下曲线图中,也可以看出,从 2022 年-2025 年,AI 芯片并没有真正变得更好只是变得更大了。

在过去四年中,计算密度(TFLOPS/mm^2)仅提高了约 15%。

而现在,随着摩尔定律的放缓,提高芯片性能的唯一途径,便是让其走向「专用」化。

专用芯片,势在必行

在 Transformer 占领世界之前,许多公司构建了灵活的 AI 芯片和 GPU 来处理数百种不同的机器学习架构。

举几个例子:

却从来没有人制造,针对特定算法的 AI 芯片(ASIC)。

因为,全新的芯片项目需要花费 5000 万-1 亿美元,甚至要用许多年的时间才能投入生产。

当 Etched 开始着手这一项目时,根本就不存在这样的市场。

突然间,这种情况一下子发生了转变。

ChatGPT 出现之前,Transformer 的推理市场规模大约是 5000 万美元。

而现在,已经达到数十亿美元。所有的科技巨头,初创公司都在使用 Transformer 模型。

大模型架构,都在走向融合趋同。自从 GPT-2 诞生以来,最先进的模型架构几乎保持一致!

OpenAI GPT系列、谷歌 PaLM、Meta Llama,甚至特斯拉的全自动驾驶系统,都采用了 Transformer 架构。

当模型的训练成本超过 10 亿美元,推理成本超过 100 亿美元时,专用芯片的出现是必然的。

在这种巨大参数规模之下,即使只有 1% 的性能提升,也足以证明 5000 万-1 亿美元的定制芯片项目是值得的。

实际上,ASIC 的速度要比 GPU 快很多个数量级。

Transformer 拥有巨大的护城河

Etched.ai 的几位创始人表示,他们相信硬件彩票——能在硬件上运行得最快、最便宜的模型,就是获胜的那一个。

而 Transformer 拥有巨大的护城河,足以在替代方案成熟之前主导各大 AI 计算市场。

理由如下——

1. Transformer 正在为每一个大型AI产品提供支持,无论是 Agent、搜索还是聊天。

为了优化 GPU 去适应 Transformer,AI 实验室已经在研发上投入了数亿美元。

无论是当前还是下一代 SOTA 模型,都是基于 Transformer 的。

2. 随着未来几年模型训练的规模从 10 亿美元扩大到 100 亿美元,再到 1000 亿美元,测试新架构的风险也急剧上升。

与其重新测试 Scalling law 和性能,不如把时间花在基于 Transformer 的功能开发上,比如多 token 预测。

3. 当前的软件栈,已为 Transformer 进行了优化。每个流行的库(TensorRT-LLM、vLLM、Huggingface TGI 等),都有在 GPU 上运行 Transformer 模型的专用内核。

许多建立在 Transformer 之上的功能,比如推测解码、树搜索等,在替代方案中都很难得到支持。

Sohu 可以通过树搜索更好地编码,能够并行比较数百个响应

4. 未来的硬件栈,也将为 Transformer 进行优化。比如英伟达的 GB200,对 Transformer Engine 就有特殊的支持。

随着像 Sohu 这样的 ASIC 进入市场,将会带来一种不可逆的趋势。

也就是说,作为「Transformer Killer」的模型需要在 GPU 上,运行得比 Sohu 上的 Transformer 更快。

而但凡出现这种情况,创始人表示,他们也会为此构建一款全新的 ASIC!

Sohu 支持多重推测解码,可以实时生成新内容

Sohu 来了!

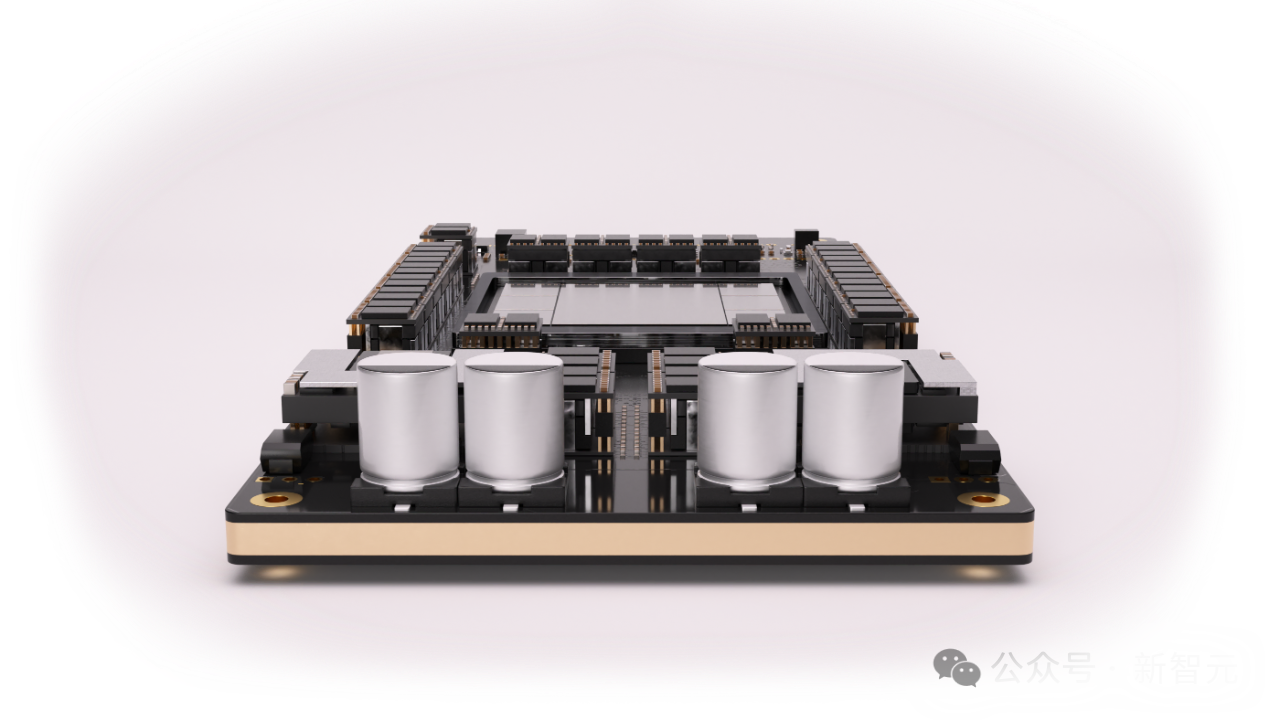

Sohu 是世界上第一个 Transformer ASIC。

通过专门化,Sohu 获得了前所未有的性能。一台 8xSohu 服务器每秒可以处理超过 50 万个 Llama 70B token,等效于 160 块 H100 GPU。

Sohu 仅支持 Transformer 推理,并支持当今所有的模型(Google、Meta、Microsoft、OpenAI、Anthropic等),以及处理未来模型的调整。

无论是 Meta 的 Llama、谷歌的 Gemini、OpenAI 的 GPT、Anthropic 的 Claude、还是 Stability AI 的 Stable Diffusion 3 等等,都可以。

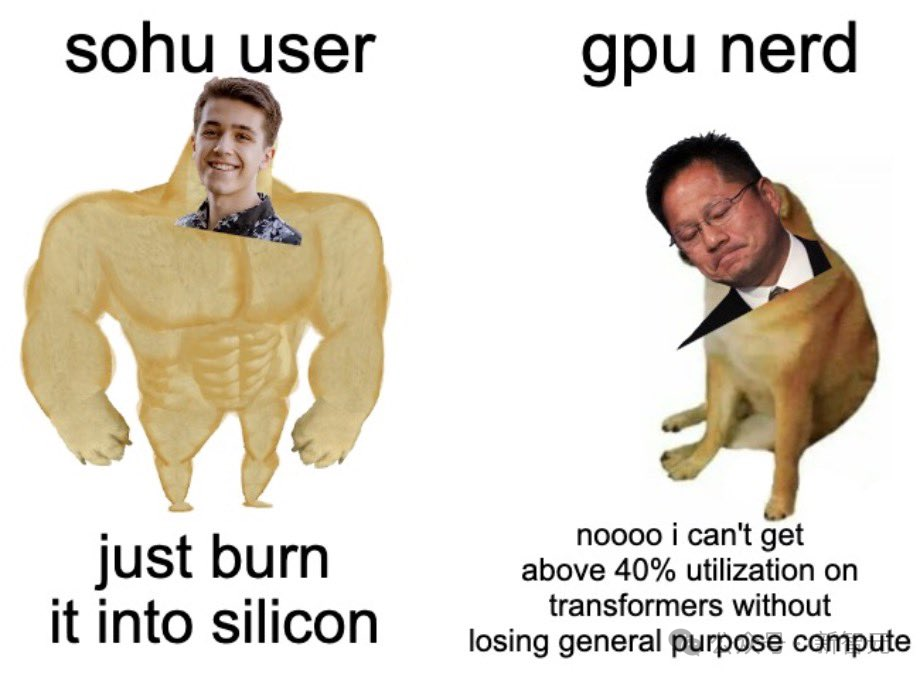

由于 Sohu 只能运行一种算法,因此绝大多数的控制流逻辑可以被移除,从而允许其拥有更多的数学模块。

结果就是,Sohu 的 FLOPS 利用率高达 90% 以上;相比之下,使用 TRT-LLM 的 GPU 仅为为 30%左右。

如何实现比GPU更多的FLOPS

目前最先进的算力——英伟达 H200,在没有稀疏处理的情况下具有 989 TFLOPS 的 FP16/BF16 算力。(超过了 Google 的新 Trillium 芯片之一)

而 2025 年推出的 GB200,将会在算力上增加 25%(每个芯片 1250 TFLOPS)。

由于 GPU 的大部分面积都用于可编程性,因此专注于 Transformer 可以容纳更多的算力。

从基本原理上来看,这一点可以很容易被证明:

制造一个 FP16/BF16/FP8 乘法加法电路(所有矩阵数学的基础构件)需要 10,000 个晶体管。H100 SXM 有 528 个张量核心,每个核心有 4×8×16 个 FMA 电路。通过计算可以得到,H100 有 27 亿个晶体管专用于张量核心。

实际上,H100 拥有 800 亿个晶体管!这意味着在 H100 GPU 上的晶体管中,仅有 3.3%用于矩阵乘法!

但问题是,如果想要为各种模型(CNN、LSTM、SSM等)都提供支持,就不得不采取这样的设计。

这时,如果选择只运行 Transformer,就可以在芯片上容纳更多的 FLOPS,且无需依赖更低的精度或稀疏处理。

推理的瓶颈是内存带宽,而非计算?

事实上,对于像 Llama-3 这样的现代模型,并非如此!

使用英伟达和 AMD 的标准基准测试——2048 个输入 token 和 128 个输出 token,大多数 AI 产品的输入都要比输出长得多(即使是新的 Claude 聊天,系统提示也有 1000 多个 token)。

在 GPU 和 Sohu 上,推理是以批次运行的。每个批次都会加载一次所有的模型权重,并在批次中的每个 token 上重复使用它们。

通常,LLM 的输入是计算密集的,而 LLM 的输出是内存密集的。所以,当我们将输入和输出 token 与连续批处理结合时,工作负载就会变得非常「计算密集」。

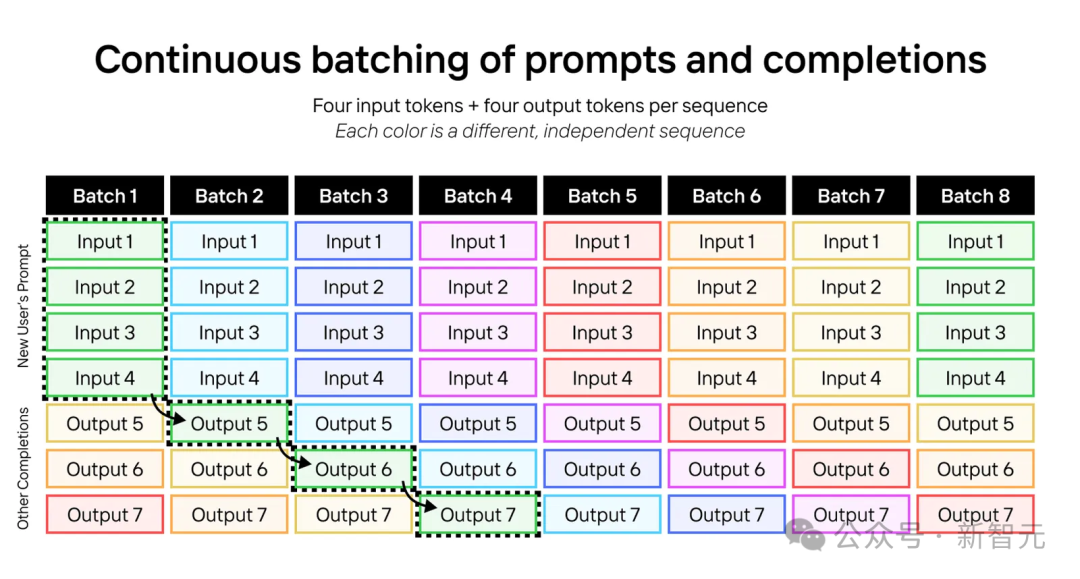

下图的示例中,就展示了连续批处理 LLM 的过程。

这个过程中,会运行带有四个输入 token 和四个输出 token 的序列;每种颜色代表一个不同的序列。

同样的技巧,就可以扩展到 2048 个输入 token 和 128 个输出 token 的 Llama-3-70B 上。

要让每个 batch,都包含一个序列的 2048 个输入 token,和 127 个不同序列的 127 个输出 token。

如果这样做的话,每个 batch 将需要大约(2048+127)×70B 参数×每个参数 2 字节=304 TFLOPs,同时只需要加载 70B 参数×每个参数 2 字节=140 GB 的模型权重,以及大约 127× 64×8×128×(2048+127)×2×2=72GB 的 KV 缓存权重。

这需要的计算,就远超过内存带宽的需求,因为一个 H200 需要 6.8PFLOPS 的计算能力,才能最大化其内存带宽。

而且,这是在 100% 利用率的情况下——如果利用率是 30%,需要的计算能力还要多出3倍。

由于 Sohu 有极高的计算能力和高利用率,我们就可以在不受内存带宽限制的情况下,运行巨大的吞吐量。

注:在现实世界中,batch 通常更大,输入长度各不相同,并且请求会以泊松分布到达。在这种情况下,Sohu的效果会更好。在这里之所以使用2048/128基准作为例子,是因为英伟达和AMD都在使用。

只需编写 Transformer 软件即可

无论在 GPU 和还是 TPU 上,软件都是一场噩梦。

处理任意的 CUDA 和 PyTorch 代码,需要的编译器极其复杂。

为此,AMD、英特尔、AWS 这些第三方 AI 芯片,都在软件上投入了数十亿,但效果依然不佳。

这里,Sohu 的好处就体现出来了——因为它只运行 Transformer 模型,所以我们只需要为 Transformer 模型编写软件!

大多数运行开源或内部模型的公司,都会使用特定的 Transformer 推理库,如 TensorRT-LLM、vLLM 或 HuggingFace 的 TGI。

这些框架往往很死板,虽然我们可以调节模型的超参数,但并不支持更改底层的模型代码。

但是,没有关系!所有的 Transformer 模型都非常相似(即使是文本、图像、视频模型),调节超参数就足够了。

这样,就足以支持 95% 的 AI 公司了,不过,最大的 AI 实验室,仍然会进行定制化开发。

工程师团队会手动调优 GPU 内核,以挤出更多的利用率,并进行逆向工程,比如哪些寄存器对每个张量核心的延迟最低。

而创始人声称,有了 Etched,我们就不再需要逆向工程了!

从驱动程序到内核再到服务框架,Etched 的所有软件都会是开源的。

如果我们想实现一个自定义的 Transformer 层,内核专家完全可以自由地去做。

Etched 已经破纪录,将成历史第一

现在看起来,Etced 的决定很疯狂。

但更疯狂的是,他们是在 2022 年做出这项决定的——那时 ChatGPT 甚至还不存在!

当时,图像和视频生成模型还是 U-Net 模型,自动驾驶汽车是由卷积神经网络(CNNs)驱动的,Transformer 架构还远未普及。

而现在,形势显然对他们非常有利。如今从语言到视觉,每个领域的顶尖模型都是 Transformer。

这种趋同验证了 Etced 的前瞻性,更使 Sohu 成为十年来最重要的硬件项目。

种种迹象表明,公司正走在史上最快芯片发布的进程中——

- 顶尖的 AI 研究人员和硬件工程师纷纷离职原团队,加入 Etced;

- Etced 会直接和台积电合作开发 4nm 工艺,并且获得了足够的 HBM 和服务器,第一年的产量可以快速提升;

- Etced 的早期客户,已经预订了数千万美元的硬件

「如果我们是对的,Sohu 将改变世界」

如果 AI 模型在一夜之间,速度飙升 20 倍,且成本降低 20 倍,会发生什么?

目前,Gemini 需要 60 多秒才能回答一个与视频相关的问题。

编码智能体的成本,比软件工程师更高,而且需要数小时才能完成任务。

视频模型每秒只能生成一帧,甚至 ChatGPT 注册用户达到 1000 万时(仅占全球用户的 0.15%),就耗尽了 OpenAI 的 GPU 容量。

即便是持续以每两年 2.5 倍的速度增加 GPU 的容量,也得需要 10 年时间,才能实现「实时」视频生成。

而现在有了 Sohu,这一切将瞬时完成。

网友表示,「AI 的未来是定制硬件,实时视频模型即将现世」!

如果当实时视频、通话、AI 智能体和搜索功能终于能够顺畅运行时,会发生什么呢?

很快,你就能知道了。

三位哈佛辍学生,挑战 AI 芯片霸主英伟达

成立于 2022 年,这家 35 人团队的初创公司 Etched,坚信一定能够击败英伟达。

到底是什么样的背景,能让三位哈佛辍学生,敢于挑战芯片行业目前最炙手可热的赛道呢?

Robert Wachen、Gavin Uberti、Chris Zhu

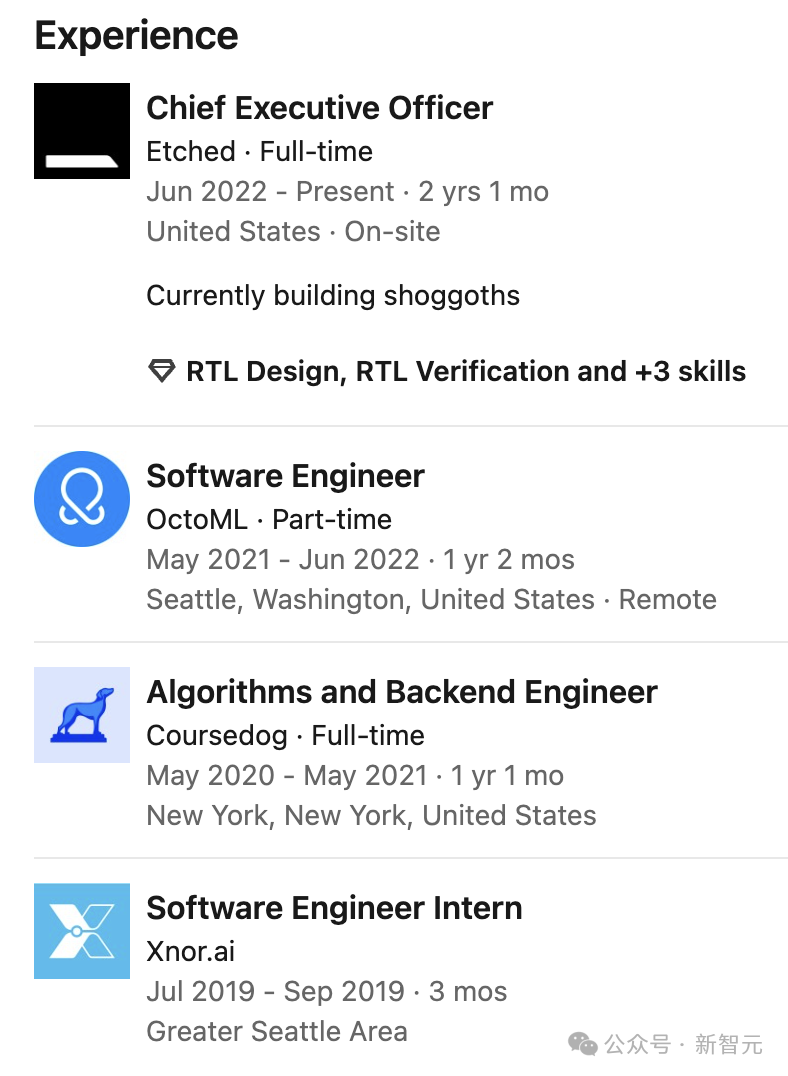

创始人兼 CEO Gavin Uberti 自 2020 入学哈佛攻读数学专业,随后在 2022 年攻读硕士学位,专业是计算机。

不过,这两段上学经历,都以辍学告终。

在创办 Etched 之前,Gavin Uberti 曾在另外两家公司分别有过一段全职和简直经历,担任了算法和后端工程师,以及软件工程师。

在进入大学之前,他参与了美国最著名的青少年科技创新大赛 FIRST Tech Challenge,团队获得了 Top 10 奖项。团队开发的自动驾驶软件排在 600 个参赛团队第二名。

他还曾在 2019 年,拿过美式数学竞赛的冠军。

另一位创始人 Chris Zhu,也是在哈佛就读时就在校外疯狂实习,甚至还没有从哈佛毕业,就已经成为兼职教员。

他个人的工作经历更为丰富些,不仅在高校 MIT 担任研究员、哈佛兼职教学研究员,还曾在亚马逊等公司做过实习。

最后一位联创兼 COO Robert Wachen 是一个多领域的创业者,曾创办了 4 家公司。

接下来,就看看他们会如何去缔造一个新的硅谷神话。

参考资料:

https://www.etched.com/announcing-etched

文章信息来自于新智元 ,不代表白鲸出海官方立场,内容仅供网友参考学习。对于因本网站内容所引起的纠纷、损失等,白鲸出海均不承担侵权行为的连带责任。如若转载请联系原出处

友情提醒:白鲸出海目前仅有微信群与QQ群,并无在Telegram等其他社交软件创建群,请白鲸的广大用户、合作伙伴警惕他人冒充我们,向您索要费用、骗取钱财!

闽公网安备35010402350923号

闽公网安备35010402350923号